RDD作为Spark对各种数据计算模型的统一抽象,被用于迭代计算过程以及任务输出结果的缓存读写。在所有MapReduce框架中,shuffle是连接map任务和reduce任务的桥梁。map任务的中间输出要作为reduce任务的输入,就必须...

”Spark 源码剖析“ 的搜索结果

1、Spark内核架构深度剖析图解 2、宽依赖和窄依赖深度剖析图解 Spark的宽依赖和窄依赖是DAGScheduler将job划分为多个Stage的重要因素,每一个宽依赖都会划分一个Stage。 3、基于YARN的两种提交模式深度剖析...

Spark源码剖析

标签: Spark 源码剖析

本书以spark 1.02版本源码为切入点,着力于探寻spark所要解决的主要问题及其解决办法,通过一系列精心设计的小实验来分析每一步背后的处理逻辑。

【读懂面经中的源码】SPARK源码解析——checkpoint过程。这是读源码的博客,主要从面经出发,深入理解Spark的checkpoint过程,期间通过源码加深理解面经中提到的原理。文章包括三部分,分别是面筋部分、checkpoint的...

spark-sourcecodes-analysis Spark源码剖析

Apache Spark 源码剖析 Apache Spark 源码剖析 Apache Spark 源码剖析

Apache Spark源码剖析,word版本,可以进行编辑。

ApacheSpark设计与实现.pdf+ApacheSpark源码剖析.pdf+Spark原著中文版.pdf

文章目录Spark源码剖析——SparkSubmit提交流程当前环境与版本前言Shell命令部分参数解析 MainSparkSubmit Spark源码剖析——SparkSubmit提交流程 当前环境与版本 环境 版本 JDK java version “1.8.0_231”...

文章目录Spark源码剖析——RpcEndpoint、RpcEnv当前环境与版本1. 前言2. RpcEndpoint2.1 核心UML图2.2 RpcEndpoint源码分析3. RpcEndpointRef3.1 RpcEndpointRef3.2 NettyRpcEndpointRef4. RpcEnv Spark源码剖析——...

文章目录Spark源码剖析——SparkContext实例化当前环境与版本前言SparkContext实例化的主要逻辑LiveListenerBus的作用createSparkEnv的过程创建不同的SchedulerBackend、TaskSchedulerDAGScheduler Spark源码剖析...

SparkContext:通常而言,用户开发的Spark应用程序的提交与执行都离不开SparkContex的支持。在正式提交应用程序之前,首先需要初始化SparkContext。SparkContext隐藏了网络通信、分布式部署、消息通信、存储体系、...

《Apache Spark源码剖析》以Spark 1.02版本源码为切入点,着力于探寻Spark所要解决的主要问题及其解决办法,通过一系列精心设计的小实验来分析每一步背后的处理逻辑。, 《Apache Spark源码剖析》第3~5章详细介绍了...

Apache Spark源码剖析,Apache Spark源码剖析,Apache Spark源码剖析 相关下载链接://download.csdn.net/download/lz199057/10430866?utm_source=bbsseo

Spark 源码剖析 转载于:https://www.cnblogs.com/TendToBigData/p/10501454.html

WordCount例子流程简介

Apache Spark:源码剖析

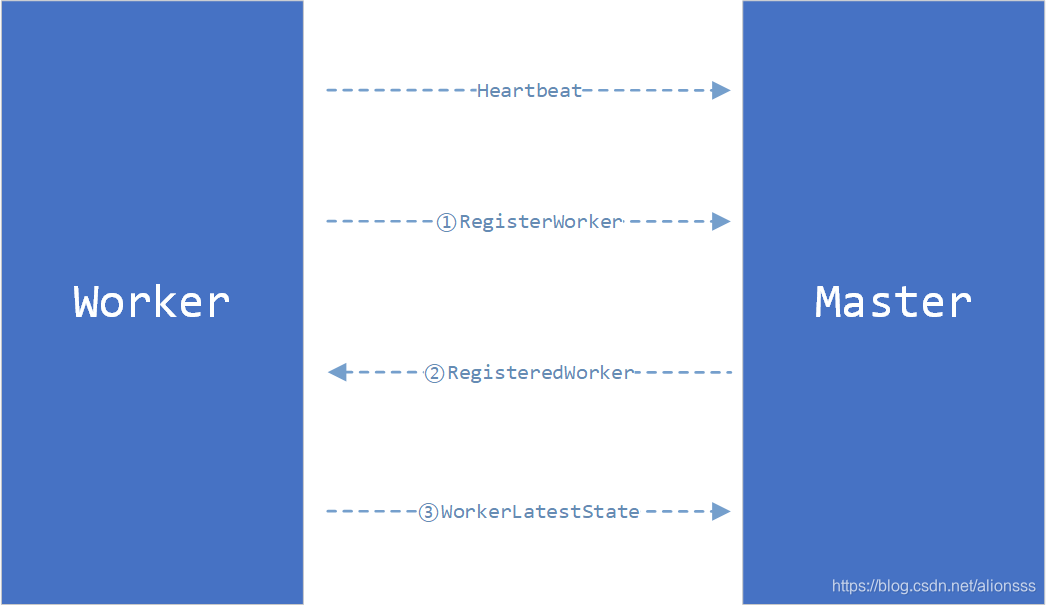

本文章是对standalone方式启动spark的源码角度说明从执行shell脚本到worker启动主要步骤,spark版本2.1.x,信息来源为spark官网和源码,如果与网上其他文章有较大的偏差,建议以我为准! 启动脚本 运行start-master....

推荐文章

- javafx预览PDF_javafx pdf-程序员宅基地

- ipv4与ipv6访问_纯ipv4访问纯ipv6-程序员宅基地

- css强制换行-程序员宅基地

- 链霉亲和素修饰的CdSe–ZnS量子点-程序员宅基地

- 饿了么4年 + 阿里2年:研发路上的一些总结与思考-程序员宅基地

- vue的sync语法糖的使用(组件父子传值)_sync传值-程序员宅基地

- 最大流最小割_网络最大流量与割的容量的关系-程序员宅基地

- queryString模块_querystring模块安装-程序员宅基地

- 安卓电量检测工具Battery Historian的使用记录_battery-historian 电量测试-程序员宅基地

- 基于QPSK的载波同步和定时同步性能仿真,包括Costas环的gardner环_qpsk符号同步-程序员宅基地